发布时间:2023-07-5 阅读量:10898 来源: 我爱方案网整理 发布人: bebop

高端的GPU,如NVIDIA的A100或AMD的Radeon Instinct MI100,包含了大量的CUDA核心或流处理器,以支持大规模并行计算。

高端的CPU,如Intel的Xeon系列或AMD的EPYC系列,通常具有更多的核心、更高的频率和更复杂的超线程技术,以提高性能。

那么GPU和CPU到底哪个更复杂呢?我们用应用场景、晶体管数量、架构设计几个维度来看看。

应用场景

GPU具有大量的计算核心、专用的存储器和高速数据传输通道。GPU的设计注重于大规模并行计算、内存访问和图形数据流处理等方面,以满足图形渲染和计算密集型应用的要求。

GPU 的核心设计理念是并行处理。相比于 CPU,GPU 拥有更多的处理单元,因此,它可以同时执行大量的并行任务。这使得 GPU 特别适合处理可以并行化的工作负载,如图形渲染、科学计算和深度学习等。

CPU则专注于通用计算和广泛的应用领域。这些CPU通常具有多个处理核心、高速缓存层次和复杂的指令集体系结构。

晶体管数量

从晶体管的数量来看,顶级的GPU通常包含更多的晶体管,这主要是因为它们需要大量的并行处理单元。例如,

CPU: NVIDIA A100 GPU包含了540亿个晶体管。

CPU: AMD的EPYC 7742,包含约390亿个晶体管。

架构设计

从架构和设计的角度来看,CPU可能会被认为更复杂。CPU需要处理各种各样的任务,并且需要优化以尽可能快地执行这些任务。为了达到这个目标,CPU使用了许多复杂的技术,如流水线、乱序执行、分支预测、超线程等。

顶级的GPU可能在硬件规模(例如,晶体管数量)上更大,而顶级的CPU在架构和设计上可能更复杂。

GPU架构

GPU 的一些关键架构特性:

大量的并行处理单元(核心):GPU 中的每一个处理单元可以被看作是一个微型的 CPU,它们可以同时执行指令。例如,NVIDIA 的一种 GPU 架构,叫做 Turing,有数千个并行处理单元(被称为 CUDA 核心)。

分层的内存架构:GPU 有一个复杂的内存架构,包括全局内存、共享内存、本地内存和常量内存等。全局内存可以被所有核心访问,而其他类型的内存则用于缓存数据,以减少对全局内存的访问延迟。

线程调度和执行:GPU 使用硬件进行线程调度,这使得它可以在执行大量线程时保持高效率。在 NVIDIA 的 GPU 中,线程是以 warp (32个线程)的形式进行调度和执行的。

特殊功能单元:除了标准的计算核心外,GPU 还有一些特殊的功能单元,如纹理单元和光栅化单元,这些都是为图形渲染特化的。在最新的 GPU 中,还有一些专门为深度学习和人工智能设计的单元,如张量核心和RT核心。

流多处理器和 SIMD 架构:GPU 使用了 SIMD(单指令多数据流)架构,这意味着在一个时钟周期内,一条指令可以在多个数据上并行执行。在 NVIDIA 的 GPU 中,每个流多处理器(SM)包含了数百个 CUDA 核心,以及其他资源如寄存器、缓存和功能单元。

具体的 GPU 架构设计会根据制造商和产品线的不同而有所不同。例如,NVIDIA 的架构(如 Turing 和 Ampere)和 AMD 的架构(如 RDNA)有一些关键的差异。然而,所有的 GPU 架构都遵循并行处理的基本理念。

CPU架构

CPU(中央处理单元)的架构设计涉及众多领域,包括硬件设计、微体系结构、指令集设计等等。

指令集架构(ISA):这是 CPU 的基础,定义了 CPU 可以执行哪些操作(例如,加法、乘法、逻辑操作等),以及如何编码这些操作。常见的 ISA 包括 x86(Intel 和 AMD)、ARM、RISC-V 等。

流水线:在现代的 CPU 中,指令被分解为多个阶段,例如,取指、译码、执行、访存和写回。这些阶段被组织成一个流水线,这样每个时钟周期内,可以有多个指令在不同阶段同时进行,从而提高了指令的吞吐量。

缓存和内存层次结构:为了减少访问内存的延迟,CPU 包含了一套复杂的缓存系统。这通常包括 L1、L2、L3 缓存等多个级别。除此之外,还有 TLB(转译后援缓冲器)等机制来加速虚拟地址到物理地址的转换。

乱序执行和寄存器重命名:这些是现代 CPU 的关键优化手段。乱序执行允许 CPU 在等待某些慢指令(如内存访问)完成时,先执行其他无关的指令。寄存器重命名则是解决数据冒险的一种方法,它允许 CPU 重新排列指令的执行顺序,而不会影响最后的结果。

分支预测:分支预测是一种优化方法,用于预测条件跳转指令的结果。如果预测正确,CPU 可以提前取指和执行后续的指令,从而避免了因为等待跳转结果而产生的停顿。

多核和多线程:现代的 CPU 通常包含多个处理核心,每个核心都可以独立执行指令。此外,一些 CPU 还支持多线程技术(如 Intel 的超线程),可以让一个核心同时执行多个线程,从而提高了核心的利用率。

以上只是 CPU 架构设计的一部分。实际上,CPU 的设计是一个极其复杂的过程,需要考虑的因素非常多,包括性能、能耗、面积、成本、可靠性等等。

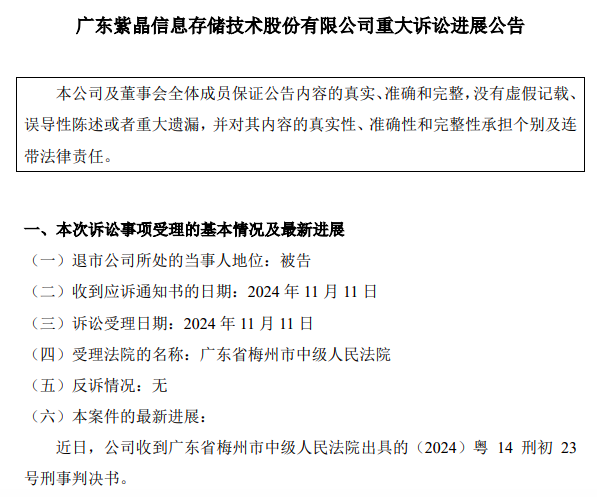

紫晶存储犯欺诈发行证券罪,判处罚金人民币3700万元;公司实际控制人郑穆、罗铁威及原财务总监李燕霞等10名核心管理人员,全部被判处有期徒刑,刑期最高达七年六个月。

近日,日产汽车和总部位于英国的自动驾驶初创公司Wayve签署协议,合作开发基于人工智能的驾驶辅助系统。

京东开启招聘存算一体芯片设计工程师计划,薪酬高达“40K-100K*20薪”

日本芯片制造商铠侠(Kioxia)计划于2026年在其岩手县晶圆厂开始生产新一代NAND闪存芯片。

一系列诉讼指控芯片制造商英特尔、AMD及德州仪器公司,未能有效阻止其技术被用于俄罗斯制造的武器。