发布时间:2025-07-22 阅读量:1083 来源: 我爱方案网 作者: wenwei

【导读】OpenAI首席执行官山姆·奥特曼(Sam Altman)近日在社交平台X上透露,公司计划在2024年底前部署百万颗GPU,以支撑其下一代AI模型的训练需求。这一规模较ChatGPT-4.5训练时使用的10万颗GPU增长10倍,显示出OpenAI在算力投资上的激进策略。奥特曼更激励团队“思考如何将这一数字再扩大100倍”,暗示未来可能迈向千万级GPU集群,以应对更复杂的AI训练任务。

AI服务器需求激增,台系代工厂迎爆发式增长

OpenAI的GPU扩张计划直接带动AI服务器需求飙升。目前,OpenAI的云端服务主要依赖微软、甲骨文(Oracle)和CoreWeave等供应商,而背后的硬件代工则由鸿海、广达、英业达、纬颖等中国台湾厂商主导。鸿海高层此前表示,“AI服务器订单已不是问题,产能才是瓶颈”,并透露订单能见度至少达两年。广达则受益于英伟达GB200服务器的强劲需求,预计AI服务器占其整体服务器营收比重将突破70%。

多集群架构成趋势,算力中心建设加速

为满足下一代大模型训练需求,OpenAI正转向**“多集群架构”,即利用分布式GPU集群协同运算。业界推测,未来OpenAI可能采用1000万颗GPU进行同步训练,这将进一步推升AI基础设施投资。此外,美国政府主导的“星际之门”(Stargate)计划也在加速推进,首座数据中心选址得克萨斯州,预计部署40万颗AI芯片**,建成后或成全球最大算力中心之一。

供应链全面受益,戴尔、美超微、技嘉等厂商受关注

除台系代工厂外,OpenAI的算力扩张也惠及全球服务器供应链。CoreWeave的主要供应商包括戴尔、美超微(Supermicro)和技嘉,而戴尔的代工订单则由纬创、鸿海、英业达等承接。随着AI服务器需求持续增长,**高算力GPU(如英伟达H100、B100)**的出货量有望再创新高,进一步巩固英伟达在AI芯片市场的主导地位。

未来展望:AI算力竞赛进入新阶段

OpenAI的百万GPU计划不仅彰显其对AGI(通用人工智能)的野心,也标志着全球AI算力竞赛进入新阶段。随着更多企业加入大模型研发,AI基础设施的需求将持续攀升,而鸿海、广达等代工厂的产能扩充将成为关键。与此同时,先进封装、液冷散热等技术也将因高密度算力需求而加速发展,推动整个AI产业链迈向更高效率与规模化。

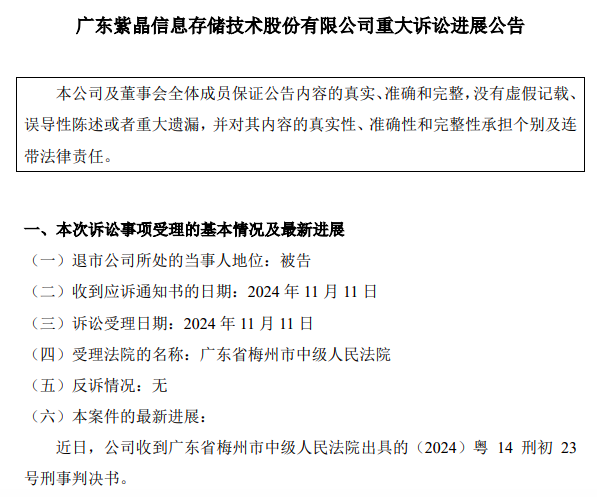

紫晶存储犯欺诈发行证券罪,判处罚金人民币3700万元;公司实际控制人郑穆、罗铁威及原财务总监李燕霞等10名核心管理人员,全部被判处有期徒刑,刑期最高达七年六个月。

近日,日产汽车和总部位于英国的自动驾驶初创公司Wayve签署协议,合作开发基于人工智能的驾驶辅助系统。

京东开启招聘存算一体芯片设计工程师计划,薪酬高达“40K-100K*20薪”

日本芯片制造商铠侠(Kioxia)计划于2026年在其岩手县晶圆厂开始生产新一代NAND闪存芯片。

一系列诉讼指控芯片制造商英特尔、AMD及德州仪器公司,未能有效阻止其技术被用于俄罗斯制造的武器。