发布时间:2023-05-10 阅读量:7812 来源: 面包板社区 发布人: Doris

GPU的起源确实是基于图形处理的需求。早期还没有专门GPU时,我们打游戏所有的逻辑处理都放在CPU执行,CPU的处理能力越来越强,但经不

住游戏画面增长的更快,这就对图形处理提出了更高的要求。

而图形处理的本质其实就是光影的计算,以下图为例,在屏幕上画一个圆非常简单。

游戏画面也是这样的逻辑,一个画面优质的游戏一定是有丰富的光影效果,而光影效果的本质其实就是在虚拟的3维空间里,模拟光的照射。屏幕中的画面其实就是特定角度下,由计算机计算出的,你应该看到的光影效果。

需要特别注意的是,游戏中你会不停的移动,也就是所有光影的效果都需要实时的计算出来。假设屏幕分辨率为1920*1080,即2073600(207.36万)个像素,游戏中每个像素都需要根据光影参数来计算显示的颜色和明暗。假设一个常见的Inter I5 CPU主频为3.2GHz,即最多每秒可做32亿次运算。但这里的一次运算只是做了一次简单的二进制加减法或数据读取,一个像素的光影计算我们可以假设需要100次运算,即CPU一秒约处理3200万次像素运算,大概15张图片,用专业点的说法,这个游戏流畅度大概是每秒15帧的样子。

一个典型的显卡GTX1060,主频是1.5GHz大概是Inter I5一半左右,但是它具备1280个计算核心。每个计算核心每秒可做15亿次运算,1280个核心每秒就是19200亿次运算,那一秒可以处理192亿次像素计算,大概925张图片,是CPU计算能力的61倍!但GPU的特性只能应用于图形计算这种可以并行的任务,若是做普通的串行任务其速度远远不如CPU。

作者:布兰姥爷

来源:面包板社区

https://mbb.eet-china.com/blog/3887969-441194.html

本文已获授权

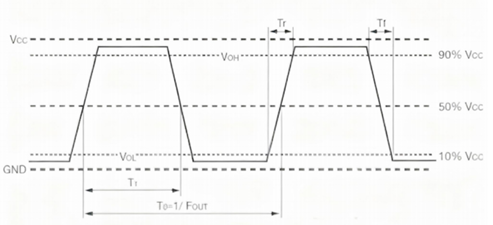

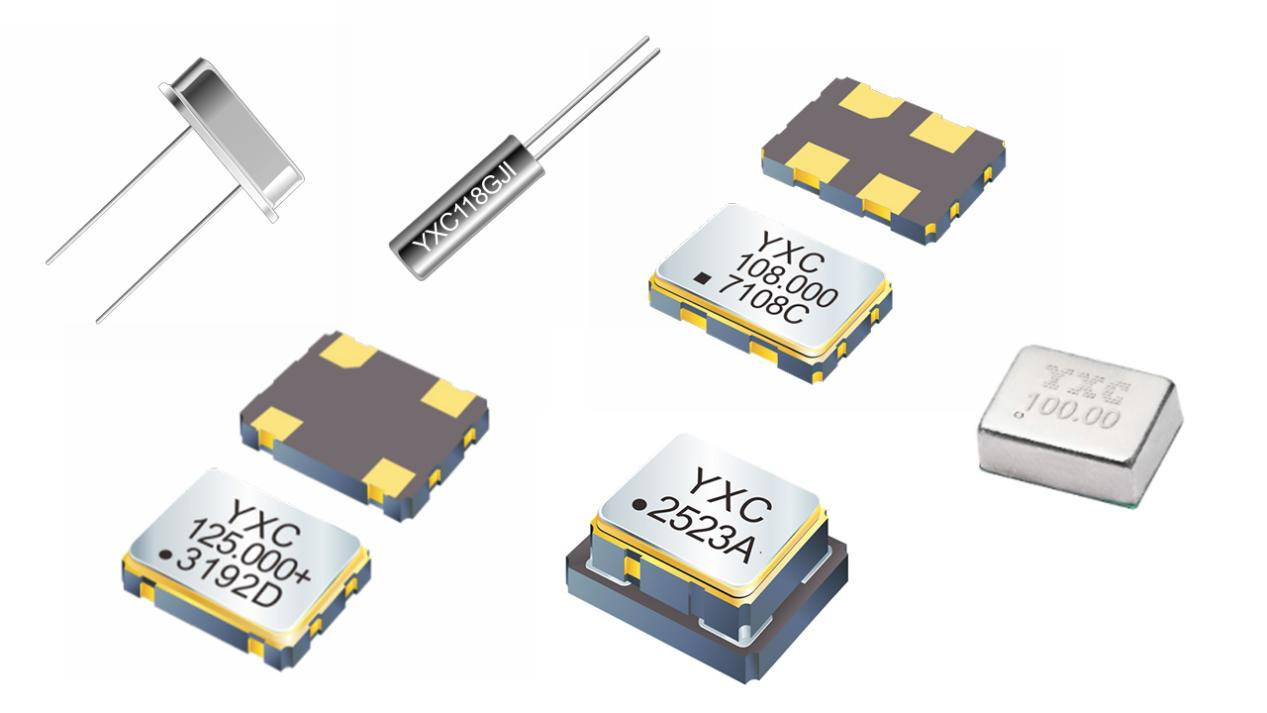

晶振(XO)的输出波形(Output Type)是衡量其性能的关键技术指标之一,其重要性不亚于封装尺寸。从技术角度区分,输出波形主要可分为正弦波和方波两大类。

“可编程”顾名思义就是其参数可根据用户的需求进行编程写入,压控温补振荡器(VC-TCXO)是温度补偿晶体振荡器和电压控制晶体振荡器结合使其震荡频率不管在任何温度下,都能实现尽可能稳定。

晶振老化通常指在特定时间范围内,石英晶振共振子频率随时间产生的变化,其单位通常以百万分之一(ppm)表示。

在电子系统设计中,晶振的性能参数直接决定了系统的稳定性和可靠性。

无源晶振与有源晶振是电子系统中两种根本性的时钟元件,其核心区别在于是否内置振荡电路。晶振结构上的本质差异,直接决定了两者在应用场景、设计复杂度和成本上的不同。